7月1日消息,前不久,华为创始人任正非接受《人民日报》采访时为中国芯片指路——芯片问题其实没必要担心,用叠加和集群等方法,计算结果上与最先进水平是相当的。

他坦言,我们单芯片还是落后美国一代,我们用数学补物理、非摩尔补摩尔,用群计算补单芯片,在结果上也能达到实用状况。

任正非认为,中国在中低端芯片上是可以有机会的,中国数十、上百家芯片公司都很努力。特别是化合物半导体机会更大。硅基芯片,我们用数学补物理、非摩尔补摩尔,利用集群计算的原理,可以达到满足我们现在的需求。

那华为是怎么做的呢?

日前,华为云官微通过一段视频展示了CloudMatrix 384超节点算力集群的威力——

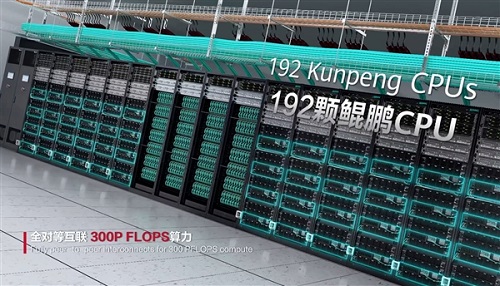

384颗昇腾NPU(昇腾910C)+192颗鲲鹏CPU全对等互联,形成一台“超级AI服务器”;

业界最大单卡推理吞吐量——2300Tokens/s;

业界最大集群算力——16万卡,万卡线性度高达95%;

云上确定性运维-40天长稳训练、10分钟快速恢复。

华为云表示,新一代昇腾AI云服务,是最适合大模型应用的算力服务。

此前,华为还发布了一一篇60页的重磅论文,提出了他们的下一代AI数据中心架构设计构想——Huawei CloudMatrix,以及该构想的第一代产品化的实现CloudMatrix384。

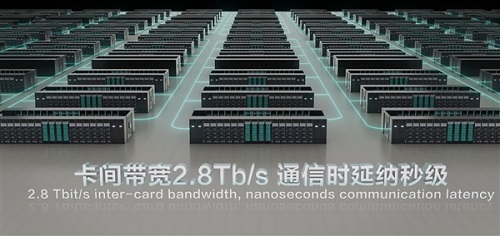

简单来说,华为CloudMatrix并非简单的“堆卡”,而是通过高带宽全对等互联(Peer-to-Peer)来设计,这也是CloudMatrix 384硬件架构的一大创新。

传统的AI集群中,CPU相当于公司领导的角色,NPU等其它硬件更像是下属,数据传输的过程中就需要CPU审批和签字,效率就会大打折扣。

但在CloudMatrix384中,CPU和NPU等硬件更像是一个扁平化管理的团队,它们之间的地位比较平等,直接通过UB网络通信直接对话,效率自然就上来了。

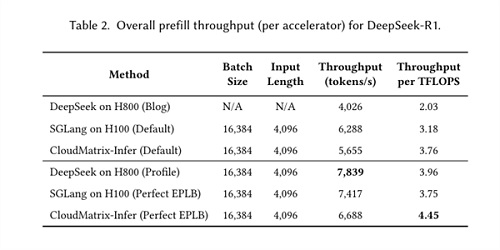

另外,论文还介绍了基于CloudMatrix384进行DeepSeek推理的最佳实践方案——CloudMatrix-Infer。

从官方给出的案例来看,CloudMatrix384预填充吞吐量达6688 token/s/NPU,解码阶段1943 token/s/NPU;计算效率方面,预填充达4.45 token/s/TFLOPS,解码阶段1.29 token/s/TFLOPS,均超过NVIDIA H100/H800上实现的性能。